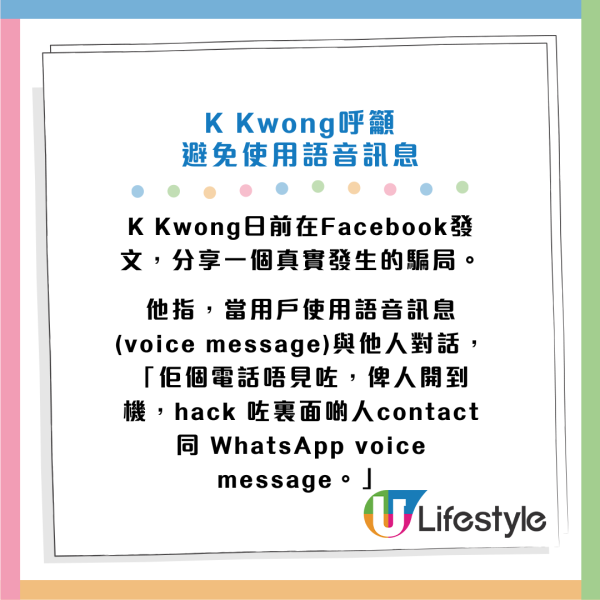

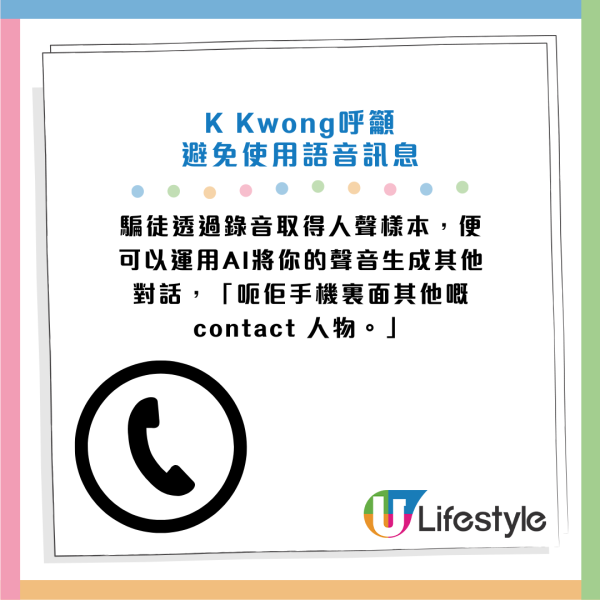

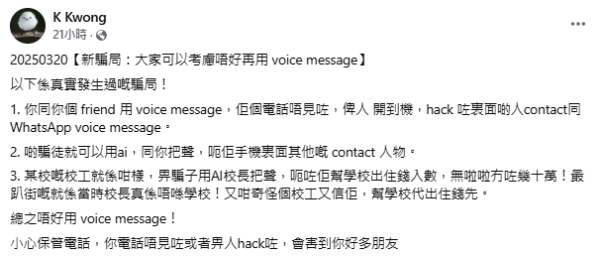

化學博士K Kwong日前在社交平台分享自己聽聞過的電話騙案,並呼籲市民考慮減少,甚至是不再使用語音訊息(Voice Message)。他指使用錄音對話有機會增外人聲樣本外洩風險,他更舉例指有校工被假冒電話錄音所騙,損失幾十萬元。有網民擔心聲音取樣容易,恐白撞電話或Cold Call乘機盜取人聲。

使用語音訊息增加聲音外流風險?

化學博士K Kwong日前在社交平台介紹新型騙局,呼籲市民少用語音訊息,以免人聲落入不法之徒手中,被騙徒以AI進行聲音模仿行騙。

網民質疑騙案真偽

帖文分享後,相比起AI換臉或變聲行騙,網民似乎對案中校工為校長墊款一事較感興趣,有人質疑「校長又點會叫校工出幾十萬」、「邊個知道校工咁有錢」、「 點可能單向收到message唔直接回電溝通吓![]() 加上佢係校工點可能會揾佢處理呢d咁嘅事。」

加上佢係校工點可能會揾佢處理呢d咁嘅事。」

有網民則表示,時下的廣東話AI軟件已十分發達,「用三秒語音素材就足夠學習,其實白撞電話都可以錄低我哋把聲。」科技日新月異,市民防不勝防,亦有人認為「直頭要見真人先好借錢,聲音影視都可以是假的」、「總之所有人叫你入錢/過數/send 條link 比你,一律ignore, 唔好理。」

▼原帖文▼

可疑來電勿盡信 提高警覺辨真偽

語音不可信之餘,接聽可疑電話時亦要提高警覺,即使對方可以講出自己的個人資料,亦切勿盡信。電台節目主持人車淑梅指自己朋友早前接獲訛稱為貸款公司的來電,對方能清楚報出自己的個人資料,警方反詐騙協調中心提醒,「對方就算講得出你全名、身份證號碼、住址等資料都好,佢都攞唔到你的錢,除非你跟佢指示過數,咁就有損失。」

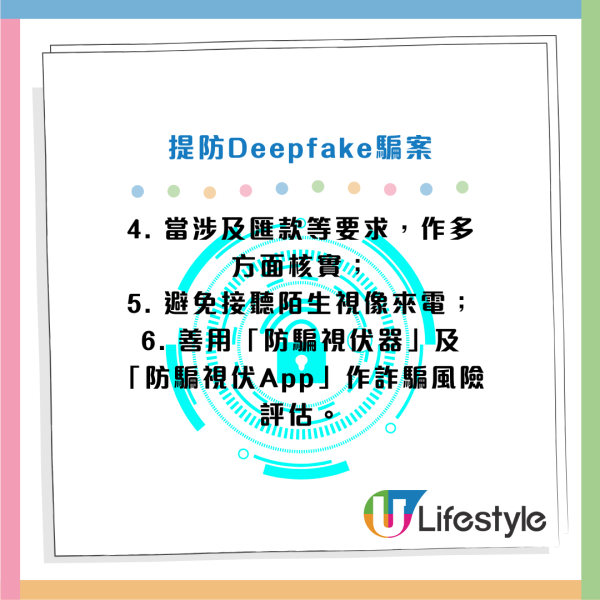

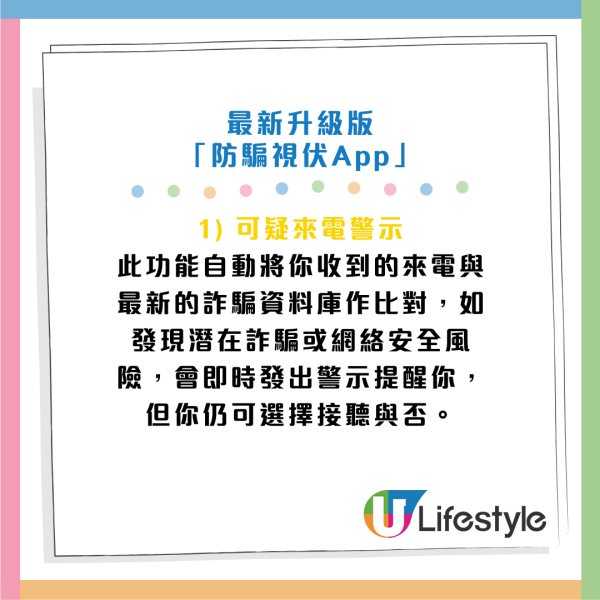

警方教路 6 招提防Deepfake騙案

警方防騙資訊平台「CyberDefender 守網者」提醒,深偽技術(Deepfake)可以在網絡世界完美複製任何人的臉孔及聲音完美複製,創造出以假亂真嘅影片或音頻。從假扮親友應急要錢,到偽裝上司要求匯錢,至AI成超級美女誘騙投資虛擬貨幣視像,深偽騙案的手法不斷升級,涵蓋不同詐騙範疇。警方教6招提高戒備,提防同類騙案。

來源:K Kwong@Facebook、車淑梅@Facebook、守網者、愛回家劇照

假日好去處

假日好去處